En un nuevo trabajo de investigación, científicos de Apple proponen HUGS (Human Gaussian Splats) para crear avatares animados en 3D a partir de vídeos monoculares cortos.

El autor principal, Muhammed Kocabas, dice que su método «toma sólo un vídeo monocular con una pequeña cantidad de fotogramas (50-100)».

Y, a partir de esto, aprende de forma automática a desenredar la escena estática y a un avatar humano que se puede animar, en 30 minutos.

Splatting Gaussiano Humano

HUGS logra representar la escena humana y la de fondo usando el Splatting gaussiano 3D, una técnica muy eficiente de renderizado.

A partir de un modelo estadístico de forma corporal, llamado SMPL, es que el modelo humano se inicializa.

Sin embargo, el detalle importante es que HUGS permite que los gaussianos se desvíen, con lo cual se capturan detalles como la ropa y el cabello.

Con un modulo de deformación neuronal se anima a los gaussianos de forma realista a través de una combinación de piel lineal.

Este movimiento coordinado hace que se eviten ‘artefactos’ (pequeñas imperfecciones) mientras refine al avatar.

Kocabas dice que HUGS «permite una síntesis de postura novedosa del ser humano y una síntesis de visión novedosa tanto del ser humano como de la escena».

HUGS es hasta 100 veces más rápido en entrenamiento y renderizado que otros métodos de generación de avatar. Y así lo demuestran los investigadores con resultados fotorrealistas luego de optimizar el sistema durante sólo 30 minutos en una GPU de juegos regular.

Incluso HUGS supera a técnicas de última generación como Vid2Avatar y NeuMan en calidad de reconstrucción 3D.

Esta nueva capacidad de modelado 3D es un gran logro que los investigadores de Apple han conseguido.

El rendimiento en tiempo real y la capacidad de crear avatares a partir de vídeos pueden desbloquear nuevas posibilidades en el futuro para:

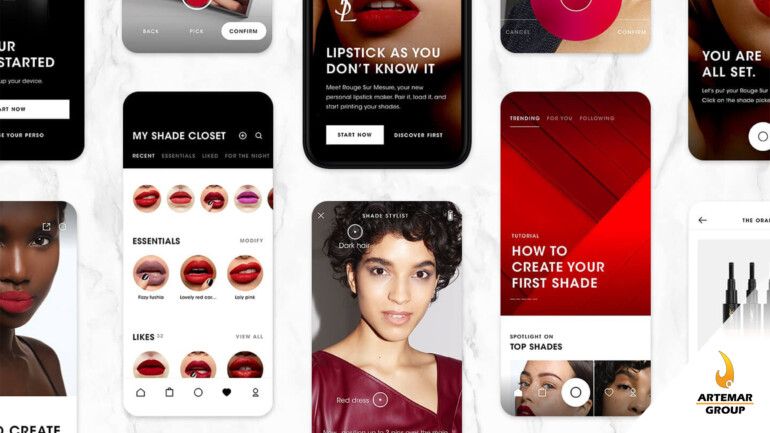

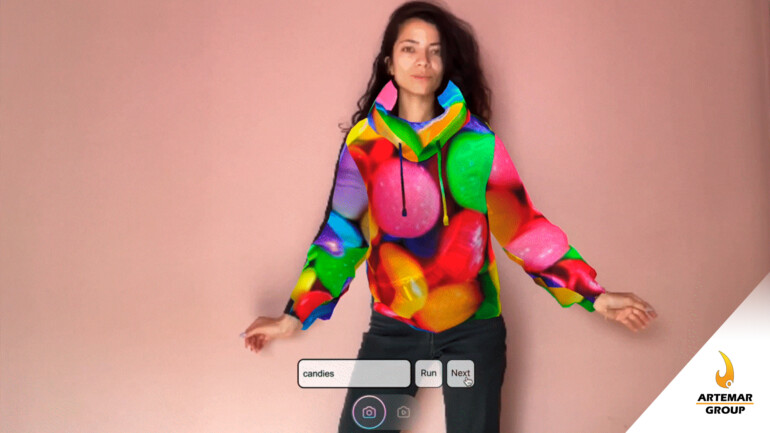

- Probarse ropa virtualmente

- Telepresencia

- Medios sintéticos

Hay mucho espacio para la creación original de escenas 3D usando simplemente la cámara del iPhone.