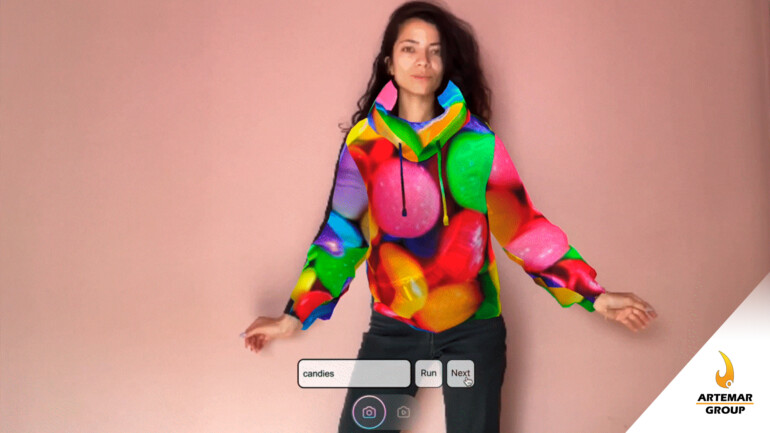

Un nuevo video parece mostrar los niveles actuales de rendimiento de oclusión y tracking manual de las Vision Pro.

El video fue publicado por un desarrollador de las Vision Pro y muestra de lo que es capaz el nuevo dispositivo de Apple.

Las Vision Pro de Apple usaran el tracking manual como el principal método de entrada. Las interacciones a nivel de sistema combinan el tracking manual con el tracking ocular para una modalidad de «mirar y tocar». Sin embargo, los desarrolladores también pueden crear aplicaciones que dejan a los usuarios interactuar de forma directa con las aplicaciones usando las manos.

El tracking de manos de las Vision Pro se divide en dos capacidades distintas:

- Tracking de manos

- Oclusión de manos

El tracking de manos es el modelo 3D estimado de la mano, sus articulaciones y la posición de las yemas de los dedos. Este modelo se usa para determinar cuándo se tocan, se agarran y se interactúa con los objetos.

La oclusión de manos se ocupa de cómo el sistema superpone la mano real en el contenido virtual. Las Vision Pro recortan la imagen de sus manos reales para mostrarlas en la escena. Esto en lugar de dibujar un modelo 3D de una mano virtual en la escena. De esta forma, se agrega otra capa de realismo al contenido virtual porque puedes ver tus propias y únicas manos.

En el video se puede ver que la oclusión manual es muy buena aunque no perfecta. Cuando está completamente rodeado de contenido virtual y se mueve de forma rápida, se puede ver algunos recortes alrededor de los bordes de la mano.

Por otro lado, la posición real del tracking de la mano va más por detrás de la oclusión de la mano, entre 100 y 200 milisegundos. No obstante, no se puede determinar la verdadera latencia del tracking de manos de las Vision Pro. Esto porque solo se tiene una vista del tracking de manos-oclusión para compararlas (que a su vez tendrán cierta latencia con respecto a las manos reales).

El video proviene de una conversación con un desarrollador de Unity. Él dice que sus primeros experimentos con Vision Pro mostraron una latencia de tracking manual muy alta. Esto, supuestamente, en comparación con las últimas capacidades de tracking manual de las Meta Quest.

Y otros desarrolladores de Unity también coinciden en que vieron una latencia similar en sus propios dispositivos Vision Pro.

No obstante, el video en cuestión es una integración de tracking manual dentro de una aplicación Unity. Esto significa que el rendimiento y la latencia del tracking manual pueden tener factores adicionales relacionados con Unity que no están presentes cuando se usan las herramientas de desarrollo Vision Pro propias de Apple.

Aun es posible que se vean mejoras adicionales a las Vision Pro. Después de todo estas gafas de Realidad Aumentada todavía no se lanzan y sus herramientas siguen en desarrollo.